Согласно докладу, подготовленному экспертами компании NtechLab и Центром развития гуманитарных технологий “Новая эра”, российские ученые уже добились значительных успехов в создании искусственного интеллекта (ИИ) с ролевыми моделями поведения и элементами эмпатии. Такие системы способны анализировать эмоции, подстраиваться под настроение собеседника и даже демонстрировать определенные черты характера.

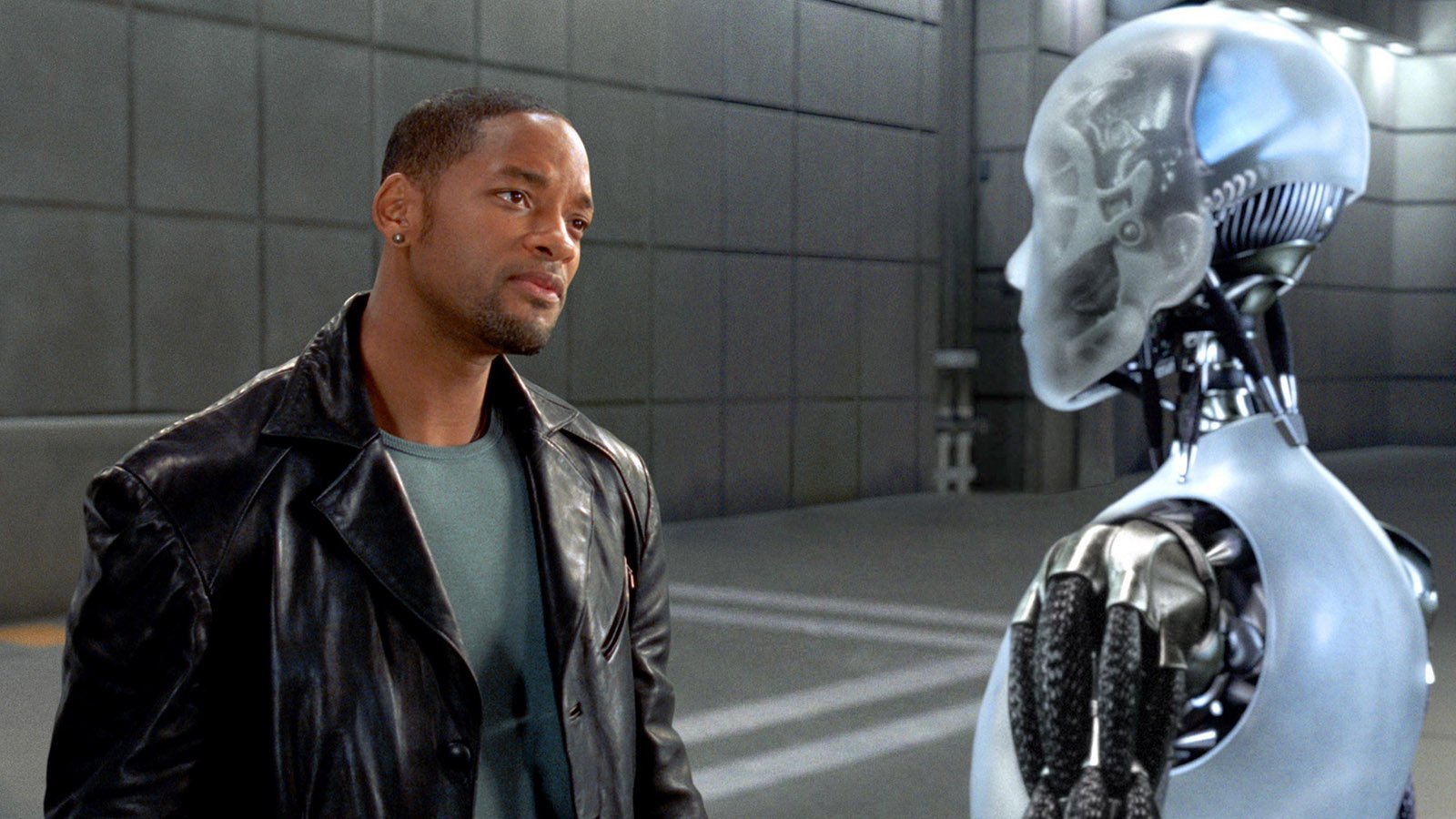

ИИ нового уровня

Как поясняют ученые, многие современные чат-боты и голосовые помощники уже обладают базовыми навыками общения, но их возможности пока ограничены. Новые же разработки обещают вывести взаимодействие с ИИ на совершенно иной уровень. Ключевым направлением исследований является создание так называемых "гуманизированных" ИИ, которые смогут не только понимать сложные запросы, но и вести диалог с учетом контекста, эмоций и социальных норм. Это открывает широкие перспективы для применения таких технологий — от медицины и образования до сферы услуг и развлечений.

Имитация сознания или его замена

Несмотря на впечатляющие успехи, речь пока идет исключительно об имитации человеческого поведения, а не о создании настоящего сознания. Российские эксперты подчеркивают, что современные ИИ-системы — это сложные алгоритмы, способные анализировать огромные массивы данных и принимать решения на их основе. Однако они лишены самостоятельного мышления, самосознания и, тем более, "души". Попытки наделить ИИ настоящим сознанием вызывают серьезные этические вопросы. Большинство специалистов сходятся во мнении, что создание полноценного искусственного разума выходит за рамки допустимого и возможного. Поэтому пока главной задачей ученых остается разработка безопасных технологий, которые смогут эффективно помогать людям, а не заменять их.

Этические аспекты и вызовы

С развитием ИИ возникает множество вопросов, связанных с его интеграцией в общество. Например, как обеспечить контроль над такими системами? Что делать, если ИИ начнет использоваться в незаконных или вредоносных целях? Как защитить личные данные пользователей, взаимодействующих с подобными технологиями?

Еще один важный аспект — это доверие. Если ИИ станет неотличимым от человека, как быть с вопросами идентификации? Например, в сфере правосудия или образования важно понимать, кто находится по ту сторону экрана — реальный человек или программа. Все это требует не только технических решений, но и разработки новых законодательных норм и стандартов.